Hầu hết các máy tính và thuật toán tại thời điểm này bao gồm cả các ứng dụng Trí tuệ nhân tạo đều chạy trên các mạch đa năng được gọi là Đơn vị xử lý trung tâm (Central Processing Unit – CPU). Tuy nhiên, lý do để khiến các phần cứng AI ngày càng được chú trọng là gì?

Giờ đây, các thuật toán AI ngày càng cần thiết và được ứng dụng rộng rãi, các mạch hoặc chip chuyên dụng ngày càng trở nên phổ biến và không thể thiếu. Các nhà khoa học máy tính và kỹ sư điện thiết kế các mạch đặc biệt, phần cứng AI có thể thực hiện cùng một công việc nhanh hơn hoặc chính xác hơn và thực hiện tính toán thường xuyên hơn.

Các mạch được tìm thấy ở nhiều dạng và ở các vị trí khác nhau, một số giúp các mô hình AI mới nhanh hơn. Chúng sử dụng song song nhiều mạch xử lý để duyệt qua hàng triệu, hàng tỷ hoặc thậm chí nhiều phần tử dữ liệu, tìm kiếm các mẫu và tín hiệu. Chúng được sử dụng ở quá trình đầu tiên trong phòng thí nghiệm bởi các nhà khoa học AI đang tìm kiếm các thuật toán tốt nhất để hiểu dữ liệu.

Những người khác đang được triển khai tại điểm mà mô hình đang được sử dụng. Một số điện thoại thông minh và hệ thống tự động hóa gia đình có các mạch chuyên biệt có thể tăng tốc độ nhận dạng giọng nói hoặc các tác vụ thông thường khác. Họ chạy mô hình hiệu quả hơn tại nơi nó đang được sử dụng bằng cách đưa ra các phép tính nhanh hơn và tiêu thụ điện năng thấp hơn.

Các nhà khoa học cũng đang thử nghiệm các thiết kế mới hơn cho các mạch. Ví dụ, một số muốn sử dụng thiết bị điện tử tương tự thay vì các mạch kỹ thuật số đã thống trị máy tính. Các hình thức khác nhau này có thể cung cấp độ chính xác tốt hơn, tiêu thụ điện năng thấp hơn, đào tạo nhanh hơn và hơn thế nữa.

Một số ví dụ về phần cứng AI là gì?

Các ví dụ đơn giản nhất về phần cứng AI là các Thiết bị xử lý đồ họa (Graphics Processing Unit – GPU), đã được sử dụng để xử lý các công việc của máy học (ML). Nhiều thư viện ML đã được sửa đổi để tận dụng khả năng tính toán song song có sẵn bên trong GPU trung bình. Cùng một phần cứng để hiển thị cảnh cho trò chơi cũng có thể đào tạo mô hình ML vì trong cả hai trường hợp, có nhiều tác vụ có thể được thực hiện cùng một lúc.

Một số công ty đã áp dụng cách tiếp cận tương tự và chỉ tập trung vào ứng dụng nó cho ML. Những con chip mới này đôi khi không nhằm phục vụ cả việc xử lý đồ họa game và các thuật toán học tập, được gọi là Đơn vị xử lý tensor (Tensor Processing Unit – TPU), chúng hoàn toàn có thể được tối ưu hóa để phát triển và triển khai mô hình AI.

Hiện nay còn có các chip được tối ưu hóa cho các phần khác nhau trong các luồng xử lý học máy. Điều này có thể tốt hơn cho việc tạo mô hình vì nó có thể sắp xếp các tập dữ liệu lớn hoặc chúng có thể áp dụng mô hình vào dữ liệu đến để giúp mô hình có thể tìm thấy câu trả lời trong đó hay không. Hoặc xuất sắc hơn, chúng có thể được tối ưu hóa để sử dụng năng lượng thấp hơn và ít tài nguyên hơn để giúp triển khai dễ dàng hơn trên điện thoại di động hoặc những nơi mà người dùng muốn sử dụng AI nhưng không muốn tạo ra các mô hình mới.

Ngoài ra, có những dòng CPU cơ bản đang được tối ưu hiệu suất để xử lý những tác vụ của ML. Thông thường, nhiều CPU tập trung vào tính toán dấu phẩy động (double-precision floating-point computations) chính xác hơn gấp đôi vì chúng được sử dụng rộng rãi trong các trò chơi và nghiên cứu khoa học. Gần đây, một số chip đang tập trung vào tính toán dấu chấm động chính xác đơn (single-precision floating-point computations) vì chúng có thể nhanh hơn đáng kể. Các chip mới hơn đang đánh đổi độ chính xác để lấy tốc độ vì các nhà khoa học nhận thấy rằng độ chính xác cao hơn có thể không có giá trị trong một số tác vụ học máy thông thường – chúng cần tốc độ hơn.

Đa số các trường hợp, nhiều nhà cung cấp dịch vụ đám mây đang giúp người dùng có thể khởi động và tắt nhiều phiên bản của các máy chuyên dụng này. Người dùng không cần phải đầu tư vào việc mua của họ và chỉ có thể thuê chúng khi họ đang đào tạo một mô hình. Trong một số trường hợp, việc triển khai nhiều máy có thể nhanh hơn đáng kể, khiến dịch vụ đám mây trở thành một lựa chọn hiệu quả.

Phần cứng AI khác với phần cứng thông thường như thế nào?

Nhiều chip được thiết kế để tăng tốc các thuật toán trí tuệ nhân tạo dựa trên các phép toán số học cơ bản giống như các chip thông thường. Họ cộng, trừ, nhân và chia như trước đây. Ưu điểm lớn nhất của chúng là có nhiều lõi (thường được chia nhỏ hơn) nên có thể xử lý dữ liệu song song.

Các kiến trúc sư của những con chip này thường cố gắng điều chỉnh các kênh để đưa dữ liệu vào và ra khỏi chip vì kích thước và bản chất của các luồng dữ liệu thường khá khác biệt so với máy tính đa năng. Các CPU thông thường có thể xử lý nhiều lệnh hơn và tương đối ít dữ liệu hơn. Các chip xử lý AI thường hoạt động với khối lượng dữ liệu lớn.

Một số công ty cố tình nhúng nhiều bộ xử lý rất nhỏ vào các mảng bộ nhớ lớn. Máy tính truyền thống tách bộ nhớ khỏi CPU; điều phối luồng dữ liệu cho cả hai là một trong những thách thức lớn nhất đối với các kiến trúc sư phần cứng. Việc đặt nhiều đơn vị số học nhỏ bên cạnh bộ nhớ giúp tăng tốc độ tính toán đáng kể bằng cách loại bỏ phần lớn thời gian dành cho việc tổ chức di chuyển dữ liệu.

Một số công ty cũng tập trung vào việc tạo ra các bộ xử lý đặc biệt cho các loại hoạt động AI cụ thể. Công việc tạo ra một mô hình AI thông qua đào tạo chuyên sâu hơn nhiều về mặt tính toán và liên quan đến việc di chuyển và giao tiếp dữ liệu nhiều hơn. Khi mô hình được xây dựng, nhu cầu phân tích các phần tử dữ liệu mới đơn giản hơn. Một số công ty đang tạo ra các hệ thống AI suy luận đặc biệt hoạt động nhanh hơn và hiệu quả hơn với các mô hình hiện có.

Không phải tất cả các cách tiếp cận đều dựa trên các phương pháp số học truyền thống. Một số nhà phát triển đang tạo ra các mạch tương tự hoạt động khác với các mạch kỹ thuật số truyền thống được tìm thấy ở các CPU. Họ hy vọng sẽ tạo ra những con chip nhanh hơn và nhiều hơn nữa bằng cách bỏ qua cách tiếp cận dựa trên kỹ thuật số và khai thác một số tính chất nguyên bản của mạch điện.

Một số lợi thế của việc sử dụng phần cứng AI là gì?

Ưu điểm chính là tốc độ. Không có gì lạ khi điểm chuẩn chung cho thấy GPU nhanh hơn CPU gấp 100 lần hoặc thậm chí 200 lần. Tuy nhiên, không phải tất cả các mô hình và tất cả các thuật toán đều sẽ tăng tốc độ như vậy và một số điểm chuẩn chỉ nhanh hơn từ 10 đến 20 lần. Một vài thuật toán khi sử dụng phần cứng AI cũng không nhanh hơn nhiều.

Một lợi thế ngày càng quan trọng hơn là sự tiêu thụ điện năng. Nếu kêt hợp phù hợp, GPU và TPU có thể sử dụng ít điện hơn để tạo ra cùng một kết quả. Mặc dù card GPU và TPU thường là những loại card tiêu thụ điện năng lớn, nhưng chúng chạy nhanh hơn rất nhiều do vậy có thể tiết kiệm điện tốt hơn. Đây là một lợi thế lớn khi chi phí điện năng ngày càng tăng cao. Họ cũng có thể giúp các công ty sản xuất “AI xanh hơn” bằng cách mang lại kết quả tương tự trong khi sử dụng ít điện hơn và do đó tạo ra ít CO2 hơn.

Các mạch chuyên dụng cũng có thể hữu ích trong điện thoại di động hoặc các thiết bị sử dụng pin khác hoặc các nguồn điện không đa dạng. Ví dụ, một số ứng dụng dựa vào phần cứng AI nhanh cho các tác vụ rất phổ biến như chờ “từ đánh thức” được sử dụng trong nhận dạng giọng nói.

Phần cứng cục bộ (local hardware) nhanh hơn cũng có thể loại bỏ nhu cầu gửi dữ liệu qua internet tới đám mây. Điều này có thể tiết kiệm chi phí băng thông và điện khi tính toán được thực hiện cục bộ.

Một số ví dụ về cách các công ty hàng đầu đang tiếp cận phần cứng AI như thế nào?

Các phần cứng chuyên dụng cho học máy phổ biến nhất đến từ các công ty sản xuất các thiết bị xử lý đồ họa. Nvidia và AMD tạo ra nhiều GPU hàng đầu trên thị trường và nhiều GPU trong số này cũng được sử dụng để tăng tốc ML. Trong khi phần lớn thiết bị này được dùng để tăng tốc nhiều tác vụ như render trò chơi trên máy tính, một số được cải tiến thiết kế đặc biệt dành riêng cho AI.

Ví dụ, Nvidia bổ sung một số hoạt động multiprecision hữu ích cho việc đào tạo các mô hình ML và giao tiếp với các lõi Tensor này. AMD cũng đang điều chỉnh GPU của mình cho học máy và gọi cách tiếp cận này là CDNA2 . Việc sử dụng AI sẽ tiếp tục thúc đẩy các kiến trúc này trong tương lai gần.

Như đã đề cập trước đó, Google sản xuất phần cứng của riêng mình để tăng tốc ML, được gọi là Bộ xử lý Tensor hoặc TPU . Công ty cũng cung cấp một bộ thư viện và công cụ giúp đơn giản hóa việc triển khai phần cứng và các mô hình mà họ xây dựng. TPU của Google chủ yếu có sẵn để cho thuê thông qua nền tảng Google Cloud.

Google cũng đang bổ sung một phiên bản thiết kế TPU vào dòng điện thoại Pixel của mình để tăng tốc bất kỳ tác vụ AI nào mà điện thoại có thể được sử dụng. Chúng có thể bao gồm nhận dạng giọng nói, cải thiện ảnh hoặc dịch máy. Google lưu ý rằng con chip này đủ mạnh để thực hiện phần lớn công việc này một cách cục bộ, tiết kiệm băng thông và cải thiện tốc độ bởi vì theo thông lệ, điện thoại đã tải công việc lên đám mây.

Nhiều công ty cung cấp dịch vụ đám mây như Amazon , IBM , Oracle , Vultr và Microsoft đang cài đặt các GPU hoặc TPU này và cho thuê chúng. Vì vậy, người dùng thông thường có thể tiếp cận nhiều dòng GPU cao cấp thông qua chia sẻ quyền sử dụng chúng. Với mô hình kinh doanh này có thể tiết kiệm chi phí hơn.

Hệ thống điện toán đám mây của Amazon cũng đang cung cấp một bộ chip mới được xây dựng dựa trên kiến trúc ARM. Các phiên bản mới nhất của các chip Graviton này có thể chạy số học có độ chính xác thấp hơn với tốc độ nhanh hơn nhiều, một tính năng thường được sử dụng cho máy học.

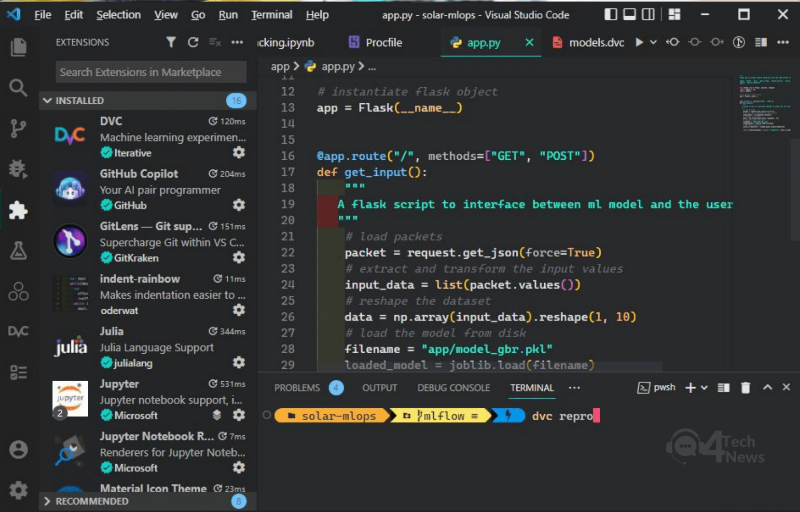

Một số công ty cũng đang xây dựng các ứng dụng front-end đơn giản giúp các nhà khoa học dữ liệu quản lý dữ liệu của họ và sau đó đưa dữ liệu đó vào các thuật toán AI khác nhau. CoLab hoặc AutoML của Google, SageMaker của Amazon, Machine Learning Studio của Microsoft và Watson Studio của IBM chỉ là một số ví dụ về các tùy chọn phần cứng AI chuyên dụng. Các công ty này có thể sử dụng sử dụng phần cứng chuyên dụng để tăng tốc các tác vụ ML và cung cấp với giá thấp hơn.

Cách các công ty khởi nghiệp tạo ra phần cứng AI

Hàng chục công ty khởi nghiệp đang tạo ra những con chip AI chất lượng tốt. Nổi bật trong số các công ty chuyên cung cấp các giải pháp phần cứng AI này xét về nguồn vốn đầu tư và mức độ quan tâm của thị trường phải kể đến:

- D-Matrix đang tạo ra một tập hợp các chip nhằm chuyển đổi các chức năng số học tiêu chuẩn đến gần hơn với dữ liệu được lưu trữ trong các ô RAM. Kiến trúc này, mà họ gọi là “in-memory computing, điện toán trong bộ nhớ”, hứa hẹn sẽ tăng tốc nhiều ứng dụng AI bằng cách tăng tốc công việc đi kèm với việc đánh giá các mô hình đã được đào tạo trước đó. Dữ liệu không cần phải di chuyển xa và nhiều phép tính có thể được thực hiện song song.

- Untether là một Startup khác phối hợp sử dụng các phép tính logic tiêu chuẩn với các ô nhớ để tạo ra cái mà họ gọi là tính toán “at-memory, tại bộ nhớ”. Nhúng các phép tính logic với các ô RAM tạo ra một hệ thống có mật độ cao nhưng tiết kiệm năng lượng. Trong một thẻ duy nhất cung cấp khoảng 2 petaflop phép tính. Untether gọi đây là “mật độ máy tính cao nhất thế giới”. Hệ thống được thiết kế để mở rộng quy mô từ các chip nhỏ, có thể cho các hệ thống nhúng hoặc di động, đến các cấu hình lớn hơn cho các trang trại máy chủ.

- Graphcore gọi cách tiếp cận của mình đối với tính toán trong bộ nhớ là “IPU” (dành cho Bộ xử lý thông minh) và dựa trên cách đóng gói ba chiều mới của chip để cải thiện mật độ bộ xử lý và hạn chế thời gian giao tiếp. IPU là một mạng lưới lớn gồm hàng nghìn cái mà họ gọi là “IPU tiles” được xây dựng với khả năng tính toán và lưu trữ hứa hẹn cung cấp sức mạnh tính toán 350 teraflop.

- Cerebras đã chế tạo một con chip rất lớn, có quy mô wafer, lớn hơn tới 50 lần so với một GPU cạnh tranh. Họ đã sử dụng silicon bổ sung này để đóng gói trong 850.000 lõi có thể đào tạo và đánh giá các mô hình song song. Họ đã kết hợp điều này với các kết nối băng thông cực cao để hút dữ liệu, cho phép họ tạo ra kết quả nhanh hơn hàng nghìn lần so với ngay cả những GPU tốt nhất.

- Celestial sử dụng quang tử – một hỗn hợp các tính toán điện tử và logic dựa trên ánh sáng – để tăng tốc độ giao tiếp giữa các nút xử lý. Loại “vải quang tử” này hứa hẹn sẽ giảm lượng năng lượng dành cho giao tiếp bằng cách sử dụng ánh sáng, cho phép toàn bộ hệ thống giảm mức tiêu thụ điện năng và mang lại kết quả nhanh hơn.

Điều gì mà phần cứng AI không thể làm được không?

Phần lớn, phần cứng chuyên dụng không thực thi bất kỳ thuật toán đặc biệt nào hoặc tiếp cận đào tạo theo cách tốt hơn. Các chip chỉ xử lý các thuật toán nhanh hơn. Các phần cứng thông thường sẽ cho kết quả tương tự, nhưng với tốc độ chậm hơn.

Sự tương đương này không áp dụng cho các chip sử dụng mạch Analog. Mặc dù vậy, cách tiếp cận khá tương đồng và kết quả không khác nhau nhiều, chỉ là nhanh hơn.

Trong một số trường hợp sẽ là sai lầm khi đánh đổi độ chính xác lấy tốc độ bằng cách dựa vào các phép tính độ chính xác đơn thay vì độ chính xác kép, nhưng những điều này thường hiếm khi xảy ra và có thể dự đoán được. Các nhà khoa học AI đã dành nhiều giờ nghiên cứu để tìm hiểu cách đào tạo tốt nhất các mô hình và thông thường, các thuật toán hội tụ mà không cần thêm độ chính xác.

Cũng sẽ có những trường hợp mà sức mạnh bổ sung và sự song song của phần cứng AI chuyên dụng không giúp ích gì nhiều cho việc tìm ra giải pháp. Khi bộ dữ liệu nhỏ, những lợi thế có thể không xứng đáng với thời gian và sự phức tạp của việc triển khai phần cứng bổ sung.

(Theo Peter Wayner)